milichan1

Senior Member

Chào các bác,

Em đang cài Spark và Scala nhưng bị lỗi.

-Spark prebuild :

Spark 2.4.0 built for Hadoop 2.7.3

Build flags: -B -Pmesos -Pyarn -Pkubernetes -Psparkr -Pkafka-0-8 -Phadoop-2.7 -Phive -Phive-thriftserver -DzincPort=3036

-Scala : scala-2.12.14

-SBT :sbt-1.5.5

-JDK 8 (trước đấy em có cài JDK 17 chắc cũng ko ảnh hưởng phải ko ạ?)

Em làm gần giống video hướng dẫn này(

)

Đây là ảnh em cap lại:

Em đã gg thấy link này (https://stackoverflow.com/questions...ell-fail-with-failed-to-find-spark-assembly-j)

Hình như lỗi là do tên folder chứa Spark có khoảng trắng? Em cũng cài ở C:/Program Files.

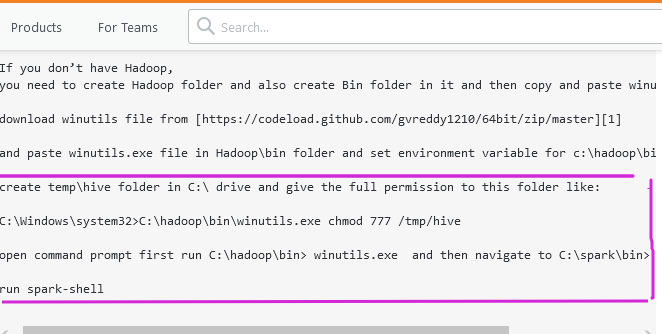

Nếu thế thì em ko muốn thêm dấu gạch dưới, có thể làm theo hướng dẫn này: tạo folder temp/hive trong ổ C và cho full quyền

"C: \Windows\system32>C: \hadoop\bin\winutils.exe chmod 777 /tmp/hive" gõ như này trong cmd ạ ?

Tiếp lại mở cmd chạy

"C: \hadoop\bin> winutils.exe" và chuyển hướng đến "C: \spark\bin> " (chỗ này là cd-change directory ạ?)

rồi chạy "spark-shell"

Em diễn đạt ko tốt lắm :'(. Mong các bác giải đáp ạ :3

Em đang cài Spark và Scala nhưng bị lỗi.

-Spark prebuild :

Spark 2.4.0 built for Hadoop 2.7.3

Build flags: -B -Pmesos -Pyarn -Pkubernetes -Psparkr -Pkafka-0-8 -Phadoop-2.7 -Phive -Phive-thriftserver -DzincPort=3036

-Scala : scala-2.12.14

-SBT :sbt-1.5.5

-JDK 8 (trước đấy em có cài JDK 17 chắc cũng ko ảnh hưởng phải ko ạ?)

Em làm gần giống video hướng dẫn này(

Đây là ảnh em cap lại:

Em đã gg thấy link này (https://stackoverflow.com/questions...ell-fail-with-failed-to-find-spark-assembly-j)

Hình như lỗi là do tên folder chứa Spark có khoảng trắng? Em cũng cài ở C:/Program Files.

Nếu thế thì em ko muốn thêm dấu gạch dưới, có thể làm theo hướng dẫn này: tạo folder temp/hive trong ổ C và cho full quyền

"C: \Windows\system32>C: \hadoop\bin\winutils.exe chmod 777 /tmp/hive" gõ như này trong cmd ạ ?

Tiếp lại mở cmd chạy

"C: \hadoop\bin> winutils.exe" và chuyển hướng đến "C: \spark\bin> " (chỗ này là cd-change directory ạ?)

rồi chạy "spark-shell"

Em diễn đạt ko tốt lắm :'(. Mong các bác giải đáp ạ :3