NVIDIA sẽ bắt đầu sản xuất hàng loạt GPU GeForce RTX 40 Series ‘Ada Lovelace’ từ giữa năm 2022

Theo chia sẻ từ leaker nổi tiếng Greymon55, dòng card đồ họa đầu bảng NVIDIA GeForce RTX 40 dựa trên kiến trúc GPU Ada Lovelace thế hệ mới được cho là sẽ bước vào giai đoạn sản xuất hàng loạt từ giữa năm 2022. Ngoài ra, thông tin chi tiết liên quan đến lộ trình gian sản xuất và thời điểm ra mắt của dòng sản phẩm rất đáng chú ý này cũng đã được tiết lộ tương đối chi tiết.

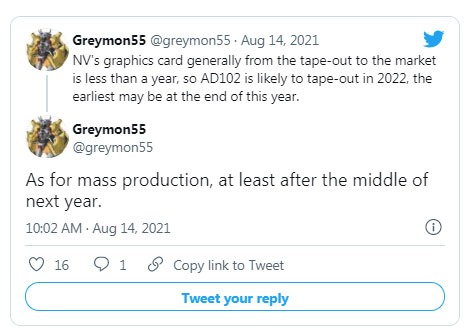

Cụ thể trong bài tweet mới nhất, Greymon55 cho biết GPU AD102 của NVIDIA nhiều khả năng sẽ là model hàng đầu trong dòng sản phẩm Ada Lovelace, dự kiến ra mắt vào cuối năm nay hoặc đầu năm 2022. Sau đó sản phẩm sẽ tiếp tục trải qua các công đoạn đánh giá thử nghiệm thực thế trước khi đi vào sản xuất hàng loạt giữa năm 2022. Điều này cũng là phù hợp với những gì các tin đồn trước đó đã nêu.

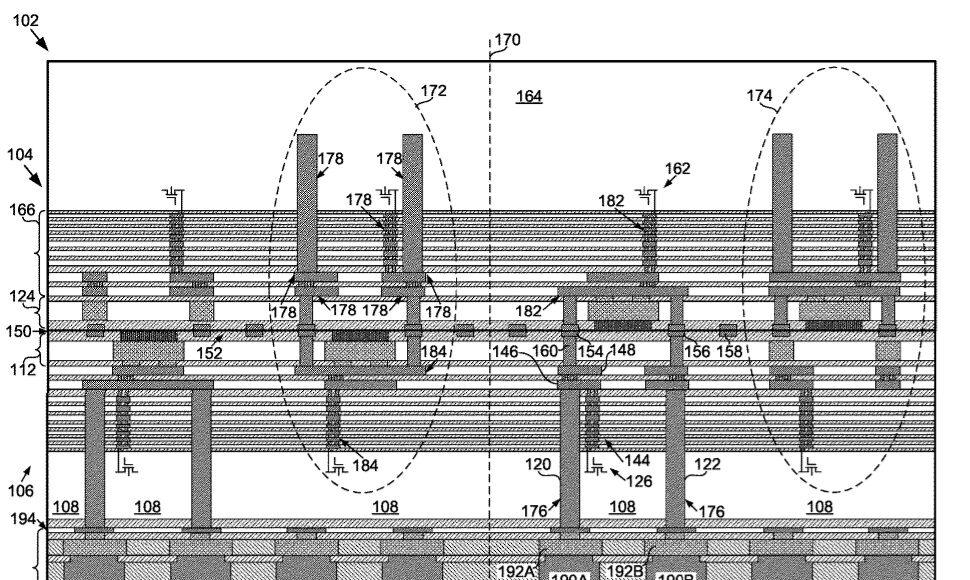

GPU NVIDIA Ada Lovelace sẽ là nền tảng cung cấp sức mạnh cho các mẫu card đồ họa GeForce RTX 40 thế hệ tiếp theo, hứa hẹn tạo ra cuộc cạnh tranh quyết liệt với dòng sản phẩm Radeon RX 7000 series dựa trên RDNA 3 của đối thủ AMD, vốn cũng đang nhận được nhiều sự quan tâm từ cộng đồng. Vẫn còn một số suy đoán về việc liệu NVIDIA sẽ sử dụng MCM không, và nếu có thì như thế nào. Như đã biết, GPU Hopper, chủ yếu nhắm vào phân khúc Trung tâm dữ liệu & AI, được cho là sẽ sớm bị “loại biên” và thay thế bằng kiến trúc MCM. Tuy nhiên, việc NVIDIA sẽ sử dụng thiết kế MCM trên GPU Ada Lovelace của mình hay không vẫn là điều chưa thể khẳng định chính xác, ít nhất là ở thời điểm hiện tại.

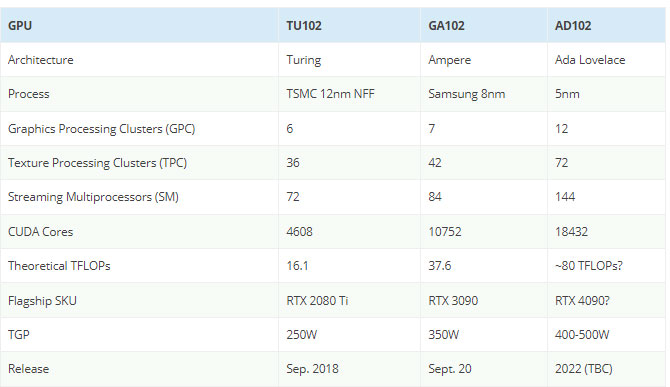

Ở phía đối diện, AMD đang cung cấp cả chip MCM và Monolithic trong các dòng sản phẩm RDNA 3 cũng như CDNA 2 của mình. Cụ thể, các GPU CDNA 2 chỉ là MCM trong khi RDNA 3 sẽ có sự kết hợp giữa MCM và thiết kế nguyên khối Monolithic. Theo nhận định từ giới chuyên gia, nhiều khả năng RDNA 3 & CDNA 2 của AMD sẽ là sự kết hợp của các nút quy trình 6nm và 5nm, trong khi NVIDIA dự kiến sẽ sử dụng nút quy trình 5nm của TSMC cho dòng sản phẩm Ada. Tuy nhiên, vẫn chưa rõ liệu GPU của Lovelace sẽ được chế tạo trên truy trình N5 hay N5P.

Trước đây, đã từng có không ít tin đồn về việc dòng sản phẩm GeForce RTX 40 hỗ trợ GPU Ada Lovelace của NVIDIA dự kiến sẽ mang tới một bước nhảy vọt về hiệu suất, tương tự như những gì đã được chứng kiến từ Maxwell đến Pascal. Tuy nhiên, việc ra mắt sẽ được đẩy sang cuối năm 2022 hoặc quý 1 năm 2023. Cà phải đến lúc đó, mọi thứ mới được kiểm chứng.

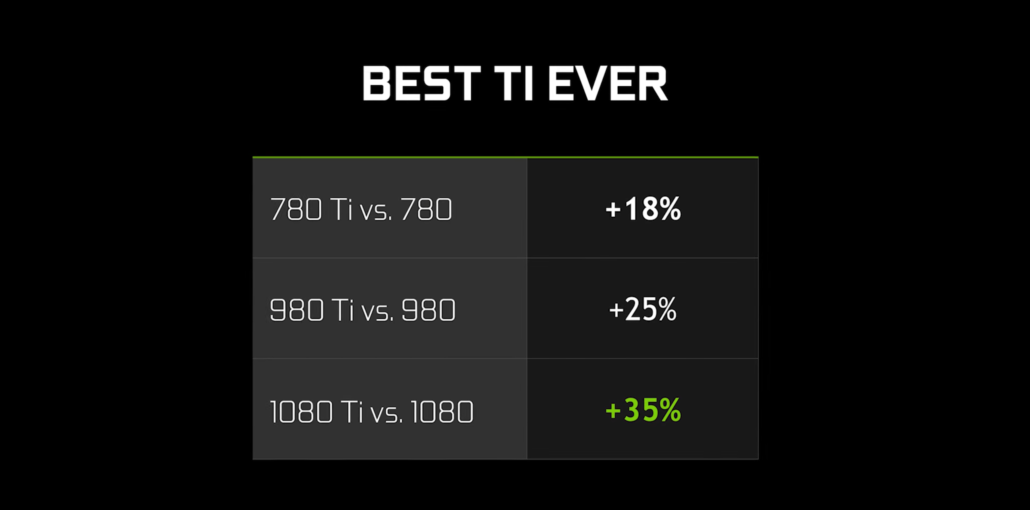

GPU NVIDIA CUDA (So sánh giữa các thế hệ):

Có tin đồn rằng GPU đầu bảng của NVIDIA trong dòng Ada Lovelace, AD102, sẽ sở hữu tối đa 144 đơn vị SM với tổng số 9216 lõi, hoặc 18.432 lõi CUDA như thuật toán mới của NVIDIA cho biết. Nếu điều đó là thật, “người kế nhiệm” của RTX 3090 có thể cho hiệu suất cao gấp khoảng 2-2,5 lần so với các sản phẩm RDNA 3 của AMD.

Tuy nhiên, tất cả hiện điều chỉ là tin đồn, mặc dù đến từ nhiều nguồn uy tín nhưng cũng chỉ dừng lại ở mức tham khảo “cho vui”. NVIDIA có kế hoạch làm mới dòng sản phẩm RTX 30 'SUPER' như một bước đệm trước khi chuyển sang thế hệ tiếp theo, đó mới là điều đáng lưu tâm hơn nào lúc này.

https://quantrimang.com/gpu-geforce-rtx-40-series-ada-lovelace-183859